Hướng dẫn cấu hình Robots.txt chuẩn SEO trong WordPress

Hướng dẫn cấu hình Robots.txt chuẩn SEO trong WordPress

1. Giới thiệu về Robots.txt

Robots.txt là một tệp văn bản nằm trong thư mục gốc của website, dùng để hướng dẫn các công cụ tìm kiếm (Googlebot, Bingbot) cách thu thập dữ liệu (crawl) trên trang web của bạn. Cấu hình Robots.txt chuẩn SEO giúp kiểm soát trang nào được crawl, ngăn chặn lãng phí tài nguyên crawl vào các trang không quan trọng, và tối ưu hóa hiệu quả SEO. Trong WordPress, bạn có thể chỉnh sửa Robots.txt thông qua plugin hoặc thủ công. Bài viết này sẽ hướng dẫn bạn cách cấu hình Robots.txt chuẩn SEO, các bước chi tiết, ví dụ thực tế, mẹo tối ưu, và cách kiểm tra hiệu quả.

2. Tại sao cần cấu hình Robots.txt chuẩn SEO?

- Kiểm soát crawl: Quy định trang nào được thu thập, tránh trùng lặp nội dung.

- Tối ưu tài nguyên: Ngăn bot crawl các trang không cần thiết (admin, file hệ thống).

- Cải thiện SEO: Đảm bảo bot tập trung vào nội dung quan trọng (bài viết, sản phẩm).

- Bảo vệ website: Chặn truy cập vào khu vực nhạy cảm (login, thư mục plugin).

3. Chuẩn bị trước khi cấu hình Robots.txt

- Yêu cầu:

- WordPress đã cài đặt (phiên bản 6.5+ khuyến nghị).

- Quyền truy cập wp-admin hoặc hosting (FTP, cPanel).

- Công cụ:

- Plugin SEO (Yoast SEO, Rank Math) để chỉnh sửa dễ dàng.

- Trình chỉnh sửa văn bản (Notepad++, VS Code) nếu làm thủ công.

- Tài khoản Google Search Console để kiểm tra.

- Kiến thức cơ bản: Hiểu cú pháp Robots.txt (User-agent, Disallow, Allow).

- Kế hoạch: Xác định trang cần chặn (admin, file tạm) và trang ưu tiên (bài viết, trang tĩnh).

4. Cấu trúc cơ bản của Robots.txt

Robots.txt sử dụng cú pháp đơn giản:

- User-agent: Chỉ định bot (VD: Googlebot, * cho tất cả).

- Disallow: Chặn bot truy cập (VD: /wp-admin/).

- Allow: Cho phép crawl trong khu vực bị chặn (VD: /wp-admin/admin-ajax.php).

- Sitemap: Thêm liên kết đến Sitemap XML (VD: Sitemap: https://example.com/sitemap.xml).

Ví dụ mặc định của WordPress:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

5. Các bước cấu hình Robots.txt chuẩn SEO trong WordPress

5.1. Kiểm tra Robots.txt hiện tại

- Truy cập tệp:

- Mở trình duyệt > Gõ tên-miền/robots.txt (VD: example.com/robots.txt).

- Nếu chưa có, WordPress tạo tệp ảo mặc định.

- Xác định nội dung: Xem có cần chỉnh sửa không (mặc định thường cơ bản).

5.2. Chỉnh sửa Robots.txt bằng plugin Yoast SEO

- Cách làm:

- Cài đặt Yoast SEO:

- Vào Plugins > Add New > Tìm “Yoast SEO” > Install Now > Activate.

- Truy cập trình chỉnh sửa:

- Vào SEO > Tools > File Editor.

- Nếu chưa có Robots.txt vật lý, nhấp Create robots.txt file.

- Chỉnh sửa:

- Mặc định Yoast đề xuất:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

- Thêm dòng Sitemap:

Sitemap: https://example.com/sitemap_index.xml

- Mặc định Yoast đề xuất:

- Tùy chỉnh thêm:

- Chặn trang không cần:

Disallow: /tag/ Disallow: /category/*?* Disallow: /?s=*

Cho phép trang quan trọng:

Allow: /blog/

- Chặn trang không cần:

- Lưu: Nhấp Save changes to robots.txt.

- Cài đặt Yoast SEO:

5.3. Chỉnh sửa Robots.txt bằng plugin Rank Math

- Cách làm:

- Cài đặt Rank Math:

- Vào Plugins > Add New > Tìm “Rank Math” > Install Now > Activate.

- Truy cập:

- Vào Rank Math > General Settings > Edit robots.txt.

- Chỉnh sửa:

- Thêm cấu hình chuẩn SEO:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Disallow: /login/

Disallow: /search/

Sitemap: https://example.com/sitemap.xml

- Thêm cấu hình chuẩn SEO:

- Lưu: Nhấp Save Changes.

- Cài đặt Rank Math:

5.4. Chỉnh sửa thủ công qua hosting

- Cách làm:

- Truy cập hosting: Dùng FTP (FileZilla) hoặc File Manager (cPanel).

- Tìm tệp: Vào thư mục gốc (/public_html/) > Tìm robots.txt.

- Nếu chưa có, tạo mới bằng cách nhấp New File > Đặt tên robots.txt.

- Chỉnh sửa: Dán cấu hình:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Disallow: /wp-includes/

Disallow: /?s=*

Sitemap: https://example.com/sitemap_index.xml - Lưu: Upload hoặc nhấp Save.

5.5. Ví dụ cấu hình chuẩn SEO

- Website blog:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Disallow: /tag/

Disallow: /?s=*

Sitemap: https://example.com/sitemap_index.xml - Website WooCommerce:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Disallow: /cart/

Disallow: /checkout/

Disallow: /my-account/

Sitemap: https://example.com/sitemap.xml

6. Tối ưu Robots.txt cho SEO

- Chặn nội dung không cần:

- Trang tìm kiếm: Disallow: /?s=*.

- Trang đăng nhập: Disallow: /login/.

- File hệ thống: Disallow: /wp-includes/.

- Mở nội dung quan trọng: Không chặn bài viết, trang tĩnh, sản phẩm.

- Thêm Sitemap: Đảm bảo bot tìm thấy Sitemap XML nhanh chóng.

- Tránh lỗi: Không dùng Disallow: / (chặn toàn bộ site).

7. Kiểm tra và gửi Robots.txt

- Kiểm tra:

- Mở tên-miền/robots.txt để xem nội dung.

- Dùng Robots.txt Tester trong Google Search Console:

- Vào Tools > Robots.txt Tester > Dán nội dung > Test.

- Gửi lên Google:

- Vào Search Console > Crawling > Fetch as Google.

- Nhập /robots.txt > Fetch để yêu cầu Google cập nhật.

8. Lợi ích của Robots.txt chuẩn SEO

- Tối ưu crawl budget: Bot tập trung vào nội dung quan trọng.

- Ngăn trùng lặp: Chặn trang không cần (search, tag).

- Bảo vệ website: Giới hạn truy cập vào khu vực nhạy cảm.

- Hỗ trợ index: Kết hợp Sitemap để tăng hiệu quả SEO.

9. Sự cố thường gặp và cách xử lý

- Bot không tuân thủ:

- Nguyên nhân: Một số bot (không chính thống) bỏ qua Robots.txt.

- Khắc phục: Dùng plugin bảo mật (Wordfence) để chặn IP xấu.

- Chặn nhầm nội dung:

- Nguyên nhân: Sai cú pháp (VD: Disallow: /blog thay vì /blog/).

- Khắc phục: Kiểm tra bằng Search Console, chỉnh sửa lại.

- Không thấy Robots.txt:

- Nguyên nhân: Tệp chưa tạo hoặc bị cache.

- Khắc phục: Xóa cache (WP Rocket), kiểm tra quyền file (755).

10. Mẹo tối ưu Robots.txt

- Sao lưu: Lưu bản sao trước khi chỉnh sửa.

- Kiểm tra định kỳ: Xem Robots.txt sau khi thêm plugin mới.

- Dùng plugin: Yoast/Rank Math quản lý dễ hơn thủ công.

- Kết hợp .htaccess: Chặn sâu hơn nếu cần (VD: chặn thư mục cụ thể).

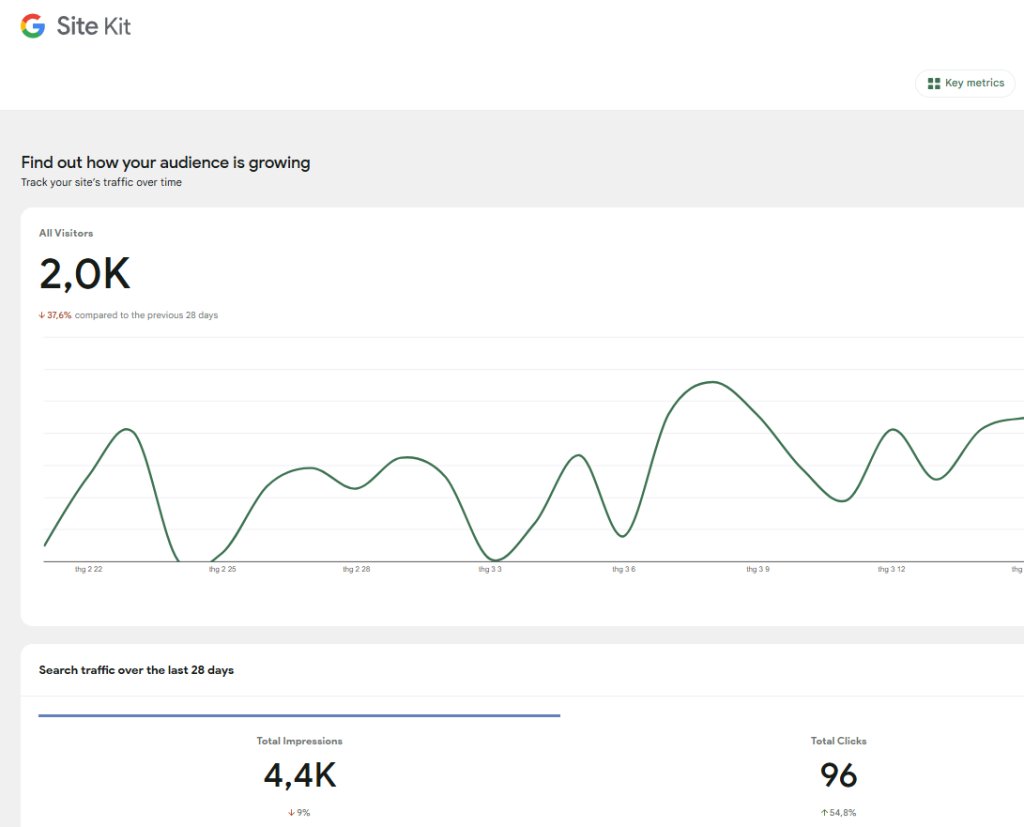

- Theo dõi crawl: Dùng Search Console > Crawl Stats để đánh giá hiệu quả.

11. Kết luận

Cấu hình Robots.txt chuẩn SEO trong WordPress là bước quan trọng để tối ưu hóa quá trình crawl và index của công cụ tìm kiếm. Dù dùng plugin như Yoast SEO, Rank Math, hay chỉnh sửa thủ công, bạn đều có thể tạo tệp Robots.txt hiệu quả trong vài phút. Với hướng dẫn trên, bạn có thể chặn nội dung không cần, ưu tiên trang quan trọng, và kết hợp Sitemap để đạt hiệu quả SEO tối đa. Hãy kiểm tra Robots.txt hiện tại của bạn ngay hôm nay, áp dụng cấu hình chuẩn, và đảm bảo website WordPress hoạt động tối ưu với các công cụ tìm kiếm!

Bài viết cùng chủ đề:

-

Cách chuyển website WordPress thành ứng dụng di động

-

Cách hạn chế đăng nhập sai nhiều lần trong WordPress

-

Cách chống spam comment trong WordPress

-

Hướng dẫn đổi URL đăng nhập WordPress để tránh hacker

-

Những lỗi bảo mật phổ biến trên WordPress và cách khắc phục

-

SEO hình ảnh trong WordPress – Những điều cần biết

-

Cách tạo và tối ưu thẻ meta trong WordPress

-

Hướng dẫn tạo Sitemap XML trong WordPress

-

Hướng dẫn tối ưu tốc độ tải trang cho WordPress

-

Tích hợp Google Analytics vào WordPress bằng plugin

-

Cách tạo biểu mẫu liên hệ bằng Contact Form 7 trong WordPress

-

Plugin tạo cache tốt nhất cho WordPress

-

So sánh Rank Math và Yoast SEO – Plugin SEO nào tốt hơn?

-

Top 10 plugin cần thiết cho website WordPress 2025

-

Cách tối ưu tốc độ theme WordPress

-

So sánh các theme phổ biến: Astra, GeneratePress, OceanWP